AI Assessmentool |

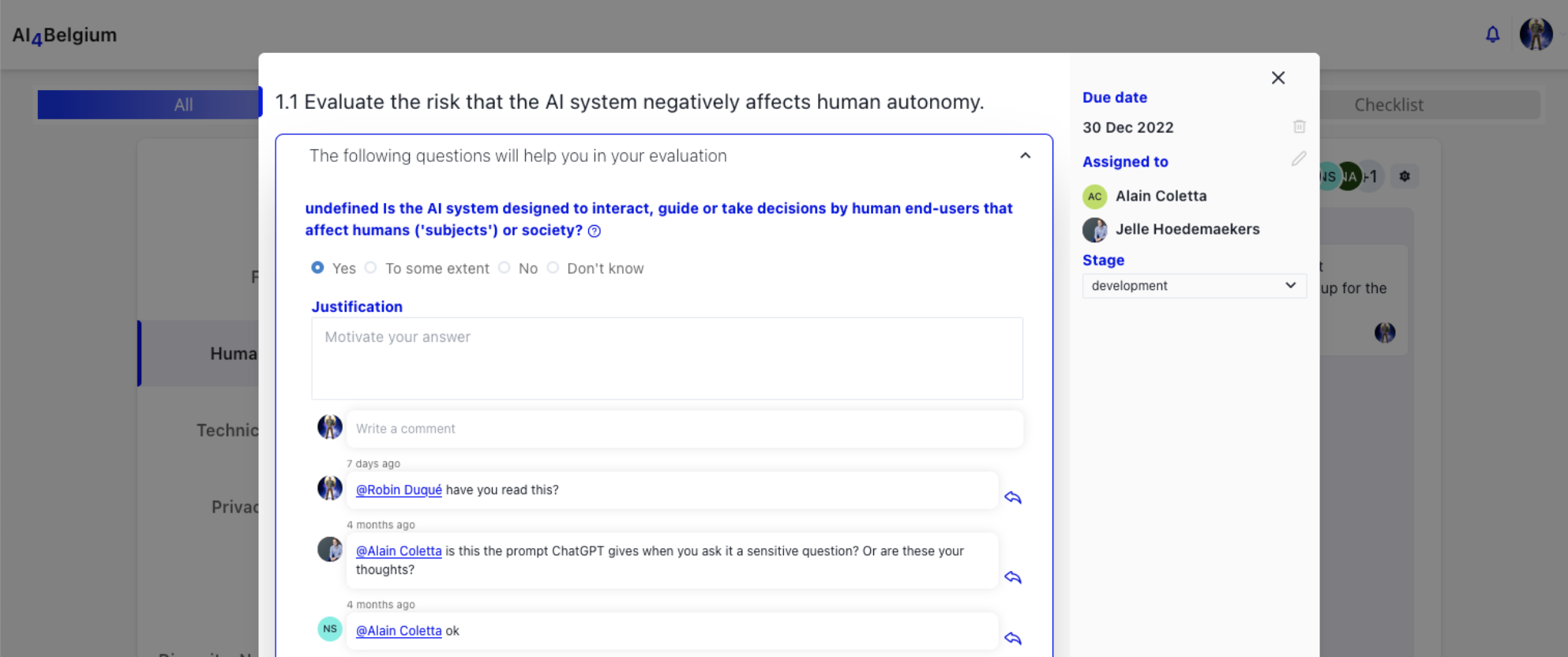

Welkom bij onze Open Source multidisciplinaire en interactieve online tool voor het beoordelen van de betrouwbaarheid van de AI-implementatie van een organisatie. Deze tool is gebaseerd op de ALTAI-aanbevelingen die zijn gepubliceerd door de Europese Commissie en is ontworpen om organisaties te helpen ervoor te zorgen dat hun AI-systemen transparant, robuust en betrouwbaar zijn. Vermijd RisicogebiedenIn de snel veranderende wereld van vandaag maken organisaties steeds vaker gebruik van AI om processen te stroomlijnen en besluitvorming te verbeteren. Het is echter belangrijk dat AI-systemen met voorzichtigheid worden ontwikkeld en geïmplementeerd, zodat ze geen inbreuk maken op fundamentele mensenrechten of vooroordelen en discriminatie in stand houden. Onze tool biedt een uitgebreide beoordeling van de AI-implementatie binnen uw organisatie, waarbij zowel sterke punten als verbeterpunten worden belicht. AanbevelingsrapportU ontvangt tevens gedetailleerde suggesties en begeleiding om de betrouwbaarheid van uw AI-systeem te verbeteren. Dit stelt u in staat om vertrouwen op te bouwen en te behouden bij uw klanten, werknemers en andere belanghebbenden, en risico's die gepaard gaan met AI-implementatie te beperken. U heeft de controleEen van de belangrijkste voordelen van onze open-source tool is dat deze gehost en volledig beheerd kan worden door uw organisatie. Dit betekent dat u volledige eigendom en controle heeft over uw gegevens en beoordelingen. Door de tool op uw eigen servers te hosten, kunt u er ook voor zorgen dat de tool voldoet aan de specifieke beveiligings- en privacyvereisten van uw organisatie. OPEN-SOURCE, pas de tool aan om te voldoen aan de unieke behoeften van uw organisatie. Deze flexibiliteit en controle maken onze tool een ideale oplossing voor organisaties die de betrouwbaarheid van hun AI-systemen willen beoordelen en tegelijkertijd volledige controle willen behouden over hun gegevens en beoordelingen. TEST HET IN DE DEMO-OMGEVING De demo-omgeving is een publiekelijk beschikbare omgeving om de AI Ethics Assessment Tool uit te proberen. Ontmoet de adviesraad AI4Belgium Ethiek & WetgevingNathalie Smuha is een juridisch geleerde en filosoof aan de Faculteit Rechten van de KU Leuven, waar ze juridische, ethische en filosofische vraagstukken onderzoekt met betrekking tot Artificiële Intelligentie (AI) en andere digitale technologieën. Nele is juridisch adviseur bij Unia, gelijkheidsorgaan en mensenrechteninstelling. Ze is gespecialiseerd in technologie en mensenrechten, met name non-discriminatie. Ze is ook actief op Europees niveau in haar rol als voorzitter van de werkgroep inzake AI van het Europees Netwerk van Mensenrechteninstellingen. Jelle is een expert op het gebied van AI-regulering. Hij werkt als ICT-normalisatie-expert bij Agoria, waar hij zich richt op de standaardisatie en regulering van nieuwe technologieën zoals Artificiële Intelligentie. Binnen Agoria werkt hij ook aan het beleid rondom nieuwe technologieën. Jelle co-leidt ook de AI4belgium werkgroep Ethiek en Recht, die kijkt naar de ethische en juridische implicaties van AI in het Belgische ecosysteem. Ik coördineer FARI - AI Institute for Common Good. Dit project is een gezamenlijk initiatief van de Université Libre de Bruxelles (ULB) en de Vrije Universiteit Brussel (VUB). Ik ben ook een geassocieerd onderzoeker bij Algora Lab (UdeM, Mila, Canada) en een adjunct-professor (UQAM, Canada). Ik heb een AI Ethics Tool ontwikkeld en gepubliceerd, en ik werk aan het verantwoord gebruik van technologieën in de gezondheidszorg. Hoe meer gedigitaliseerd we leven, hoe meer gepersonaliseerde beslissingen we krijgen op basis van onze informatie. Mijn doel is om te achterhalen hoe deze zaken werken en mensen te laten begrijpen wat er gebeurt met data. Ik vind het opmerkelijk dat er zo weinig bekend is over data in het tijdperk van big data. Mijn methode bestaat uit het blootleggen van het verborgen leven van data door deze processen in begrijpelijke teksten, scenario's en visuals in kaart te brengen. Vervolgens gebruiken we co-creatie sessies om de huidige praktijken af te stemmen op de verwachtingen van eindgebruikers, regelgevers of vernieuwers. Yves Poullet was rector aan de Universiteit van Namen (2010-2017). Hij is oprichter en voormalig directeur van CRIDS (1979-2009). Ook was hij twaalf jaar lid van de Privacybeschermingscommissie. Nathanaël Ackerman is de algemeen directeur van de AI4Belgium-coalitie en Digital Mind voor België, aangesteld door de Staatssecretaris voor Digitalisering. Hij is ook hoofd van het team 'AI - Blockchain & Digital Minds' voor de Belgische Federale Overheidsdienst Strategie en Ondersteuning (BoSa). BeschrijvingDeze tool is ontworpen om teamleden met uiteenlopende expertise in staat te stellen samen te werken en gesprekken te voeren over belangrijke onderwerpen met betrekking tot de betrouwbaarheid van hun AI-implementatie. Beoordeelde onderwerpen

|